副刊

無名周記:AI的另類美國史

【明報專訊】自2022年ChatGPT進入大眾視野,生成式人工智能(AI)的新聞總是鋪天蓋地:一方面它被譽為擁有博士級智商,另一方面卻又常犯低級錯誤。即使如此,AI仍然搶奪人類飯碗:老牌顧問公司McKinsey就縮減人手,並引入12,000個AI agent。不過,AI無論怎改進,仍然無法杜絕「老作」的問題,澳洲一名律師向維多利亞省最高法院提交的文件,被發現包括AI老作的案例,律師要向法院道歉。至於AI引導用戶做出自毁行為更叫人擔心……回頭看看我的ChatGPT,我雖然一直等待未來戰士式的AI,但眼前那個卻仍然是一個沒有自知之明的助手,信心爆棚,卻給你連串錯誤。

OpenAI總裁Sam Altman語不驚人誓不休,每次發言都好像經過SEO(Search Engine Optimization),把握一切能吸引眼球的關鍵字。OpenAI 8月初公布千呼萬喚始出來的最新模型GPT-5,關鍵字是「博士級」。公司宣稱它在寫作及編程上擁有「博士級」能力。Sam Altman當時稱,該模型比之前的模型「好很多」:使用GPT-3好像跟一個中學生說話,GPT-4就像是跟大學生說話,「GPT-5是首次令我真正覺得跟一個專家說話,就像博士級專家」。

「博士級」AI製圖錯漏百出

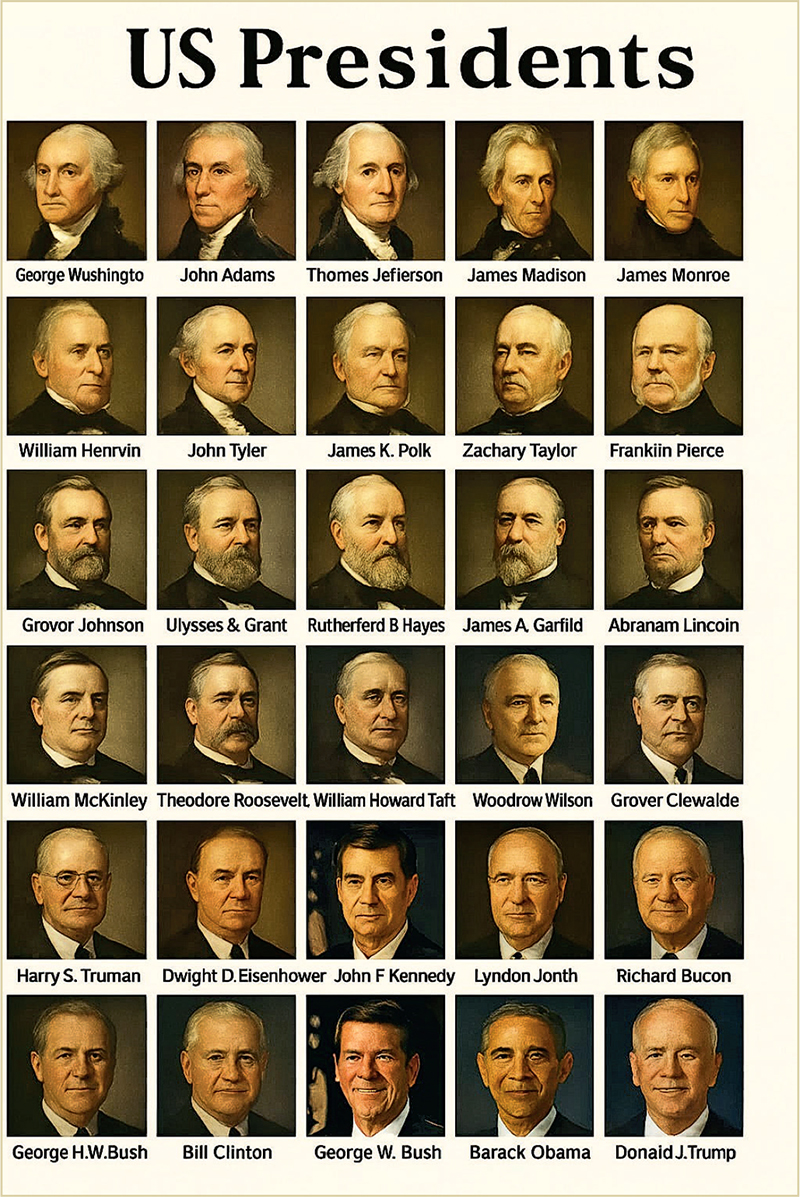

在博士滿街走的年代,人們仍然迷信學歷,AI也要像個博士才夠派頭。不過,GPT-5並沒有讓我信服。「高分低能」這句人們用來調侃博士的笑話,用在它身上同樣合適。叫ChatGPT製作一張歷任美國總統圖表,它先從網絡蒐集資料,列出歷任美國總統:很好,沒有錯。不過,製作出來的圖卻錯漏百出。不少名字拼錯,彷彿是未見過英文字母的人抄寫英文的錯誤,例如Abranam Lincoin(應是Abraham Lincoln),至於肖像也只是劣質仿製品,連仿製對象也搞錯,特朗普的肖像是以拜登肖像為基礎生成的,特朗普應該不會太高興。

我叫ChatGPT檢查一下成品,它倒也老實,逐一列出錯誤,並承諾可以再生成一張正確無誤的圖像。但結果依然錯漏百出。我再要求fact-check,它再次老實承認問題,並再次表示可以修正。我沒有時間跟它糾纏下去。打從2022年跟ChatGPT交手開始,我早已知道對它要「循循善誘」,我索性直接提問:「這是否AI生成圖像的限制?」它這次沒有死撐,坦承確實如此,並有條不紊地列出原因,例如欠缺內置的正確圖像庫、生成圖像時無法提供來源、生成圖像的文字處理能力仍然不足等。它提出折衷方案,由它提供正確無誤的純文字總統年表,以及圖表設計規格,建議我據之使用Photoshop等軟件自行製作。其他網民也發現GPT-5製作地圖錯漏百出,博士級的威力原來不過如此,也叫圖像設計者鬆一口氣。

惡意偽造文獻流傳成隱憂

我說,那麼AI圖像只是just for fun罷了?它說差不多,「AI藝術並不是要作為權威來源,而是首先作為一種創意工具」。如果大家都只是用AI來製作吉卜力風格圖像放上網分享,雖然叫人煩厭,但也無傷大雅。問題在於,當AI生成的「另類美國總統圖表」之類的假貨在網上流傳,便不得不令人擔心:歷史有不少案例涉及偽造歷史文獻來宣傳某些意識形態,例如1903年在俄羅斯報章刊登的The Protocols of the Elders of Zion,便是用來「證明」猶太人密謀操控世界的偽造文件,對日後的反猶主義影響深遠。今天網絡上早已充斥不少模仿歷史的黑白照片,雖然是just for fun,但也顯示生成AI重寫歷史並非無稽之談。就算沒有人惡意大規模製造偽史,AI生成的仿歷史圖充斥互聯網仍然有後果,尤其是如今AI已經深入到網絡搜尋中。

Perplexity AI的Discover整合不同新聞來源呈現資訊,用戶甚至不用點擊網站連結便可以一覽無遺,就算傳統搜索引擎如Google也提供AI Overview,根據用戶的搜索字眼來匯合網上資訊直接提供答案,令用戶毋須進入相關網站也可一目了然——當然前提是你相信AI沒有騙你。這種AI搜尋早已引起內容供應者不滿,認為被偷走點擊率,但最大問題是,這些AI整合文末雖然往往附上來源,貌似專業,但生成文章跟來源是否有關,那些來源是否可信,除非你專門找AI的錯處,大概沒有人會深究。網上便有不少網民分享,那些AI整合如何看似專業,但實際上跟其列舉的來源無關,有時也錯誤理解來源的內容。

AI供應商當然強調有嚴格把關,如Google便稱其AI Overview是根據網站排名來決定引用來源。然而,AI製作的虛假內容更早已無處不在,難保那些虛假內容會污染AI搜尋。就算假設AI搜尋的都是有信譽的網站,但大型語言模型(LLM)本身難逃幻覺,可以憑空揑造,這缺點暫時仍未見改善。再者,LLM對同一問題每次顯示的答案可能不同,甚至會因人而異。

加劇「曼德拉效應」

文字資訊已有難以解決的問題,圖像所引起的問題可以更嚴重。回頭看看ChatGPT給我的另類美國總統圖,一般人可能可以看出華盛頓、林肯、特朗普這些較知名的總統肖像和名字有問題,但對於那些較冷門的總統就可能不察覺了。要利用AI製作假歷史的大可以潛而默化,悄悄改變大眾的記憶。人們的記憶本來就不怎樣可靠,很容易受影響,記錯十分常見,而Fiona Broome 2009年提出「曼德拉效應」(南非總統曼德拉2013年病逝,但她發現很多人都記錯他在1980年代獄中死亡)後,社交網站便不時有人發現很多人對某個事件、詞語或圖像,都記得相同卻錯誤的細節。很多人以為是真的集體記憶,原來是以訛傳訛的虛構記憶。《國家地理》雜誌上月便有專文討論AI是否會加劇「曼德拉效應」。

文章引述專研錯誤記憶的德國波茨坦大學社會心理學教授Aileen Oeberst說,記憶之所以如此容易出錯,部分原因在於大腦使用同一個區域來進行想像與儲存記憶,如果人們反覆想像某件事情,他們往往會在某個時刻相信自己真的經歷過,並且把它當作真正的記憶。已故教宗方濟各身穿Balenciaga羽絨外套算是最早一批網上瘋傳的AI生成圖片,相信很多人都看過,可能不少人並不意識到它是假的,就算有看過相關的fact-check,人們仍然會對該圖留下深刻印象,久而久之便當作真實記憶。Oeberst解釋,人的大腦天生便容易遺忘資訊的來源,而非內容本身。換句話說,人們可以記得一張錯誤的AI圖像是什麼樣子(如身穿羽絨外套的方濟各),卻忘了自己本來不應相信該幅圖。

建可信群體防記憶遭扭曲

互聯網已大幅改變了人類記憶模式,AI生成的內容誓將進一步對人類記憶造成衝擊。那麼人類可以怎樣防止記憶遭扭曲?靠AI公司把關?你真的相信老在吹噓AI多能幹的企業家嗎?最終還是一個老掉牙的方案:找你信任的人。馬里蘭大學資訊學院教授Jen Golbeck對《國家地理》雜誌說,關鍵在於建立一個可信任的群體,比如記者、科學家、政治人物,即使他們說的話不中聽,但你評估過他們仍然是提供正確資訊者。不過,現在人們都當AI是朋友,又覺得它很聰明又中立,說話又討人歡喜;對專家反而愈來愈不信任,建立一個可信任的群體又談何容易?

文˙林康琪

編輯˙林曉慧

fb﹕http://www.facebook.com/SundayMingpao